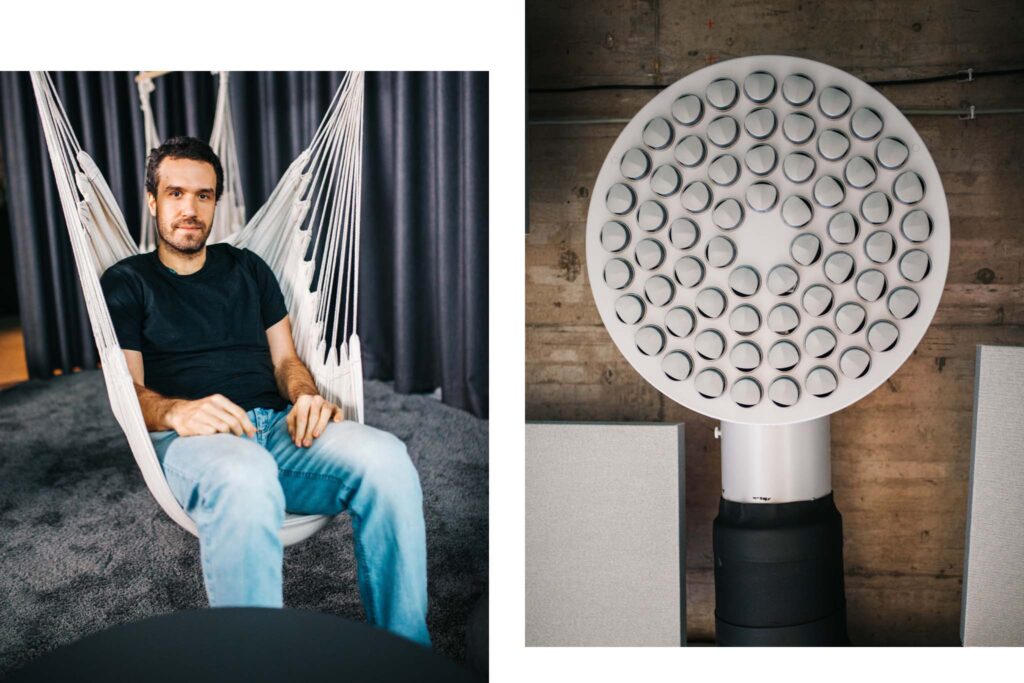

Sociálne siete nás neustále zaplavujú hoaxmi aj nenávistnými príspevkami. V boji s nimi zatiaľ ťaháme za kratší koniec. Kempelenov inštitút inteligentných technológií (KInIT) chce na tento problém využiť umelú inteligenciu. Jej algoritmy sa však najprv potrebujú od ľudí naučiť rozoznávať dezinformácie. Jakub Šimko, ktorý na technológii pracuje, nám vysvetlil, ako umelá inteligencia funguje a čo nás spolupráca so strojmi môže naučiť.

V rozhovore sa ďalej dočítate:

- či stroj dokáže porozumieť textu, ktorý napísal človek,

- ako fungujú algoritmy sociálnych sietí,

- či by nástroj mohli zneužiť ľudia šíriaci dezinformácie,

- podľa akých znakov sa dá obsah označiť za hoax.

Problém s dezinformáciami je vážny. Dostali sme sa do bodu, keď si sami nevystačíme a na jeho riešenie potrebujeme umelú inteligenciu?

Ak by som aj mal pocit, že by sme na to stačili, prečo si nepomôcť, ak sa to dá aj umelou inteligenciou? Šírenie hoaxov, dezinformácií a hejtu má aj technologický aspekt. Sociálne médiá síce niekto mohol vymyslieť s dobrým úmyslom, no v súčasnosti sú nastavené tak, aby generovali zisk svojim vlastníkom, a zároveň tak, že sa, zrejme nechtiac, nepravdivé informácie cez ne šíria rýchlejšie než tie pravdivé.

Hoaxy a nezmysly sú atraktívnejšie, oslovia viac čitateľov. Všimli si to aj algoritmy, ktoré nám odporúčajú obsah, a preto ich viac šíria. Touto skutočnosťou by sme síce ľudí mohli vyviniť, no aj oni nesú svoj diel viny, lebo nie sú dobre pripravení na dnešnú dobu. Nemyslia kriticky, lebo ich to nikto neučil a neviedol ich k tomu. Pritom ľudia, keby ste sa ich spýtali, by sami seba považovali za kriticky mysliacich. Hlúpi sú tí ostatní, mne sa to nemôže stať, že by mnou niekto manipuloval, niekto ma oblafol. No ruku na srdce, koľkokrát sa nám to už stalo? Koľkokrát sme zle nakúpili alebo zle volili?

Môže mať šírenie hoaxov aj čisto technologické riešenie?

Nie, čisto technologické riešenie neexistuje. Vezmite si email, naň nevplývajú žiadne algoritmy. Do schránky mi môžu prísť seriózne správy aj bludy. Mail je demokratický, keď ho pošlem, zakaždým bude doručený.

Podobne fungovali príspevky na sociálnych médiách v roku 2008. Vy ste zdieľali post a ten sa objavil všetkým vašim známym. Vo Facebooku si však uvedomili, že obsahu je na sieti priveľa, treba ho filtrovať, a vtedy začali nastavovať odporúčacie nástroje. Neskôr zistili, že je dôležité, aby používateľov na platforme udržali čo najdlhšie, a že by obsah mali vyberať podľa toho.

Hoaxy a nezmysly sú atraktívnejšie, oslovia viac čitateľov. Všimli si to aj algoritmy, ktoré nám odporúčajú obsah.

Najviac vašu pozornosť zaujme obsah, ktorý je emocionálny. Na jednom konci spektra sú mačičky, ale tie vás nezaujmú až tak ako niečo, čo vás rozčúli a negatívne chytí za srdce. Vieme, že algoritmy na sociálnej sieti preferujú diskusné interakcie. Počítajú aj lajky, srdiečka či emotikony, ale najviac si cenia diskusiu, ideálne pri kontroverzných témach, kde sa ľudia hádajú. Zlaté mačičky tiež generujú komentáre, ale nie je ich toľko. Algoritmy merajú aj to, či sa na príspevok vraciate, a to sa deje vtedy, keď pod ním chcete debatovať.

Riešením by bolo, keby sme si viac všímali pozitívny obsah a viac naň reagovali?

To sa môžeme len domnievať, no verím, že by nám pomohlo, keby sme sa prestali rozčuľovať. Keby používatelia boli nad vecou a nechodili sa na sociálne siete hádať, algoritmy by si to zmerali a dezinformácie by nemali taký veľký dosah.

Skúste nám teda vysvetliť, ako by mohol pomôcť váš projekt.

Snažíme sa pracovať na metódach, ktoré by dokázali posúdiť, či by mohol vybraný obsah obsahovať dezinformácie. Umelá inteligencia zatiaľ nevie obsah vyhodnotiť jednoznačne, no môže s rozumnou mierou istoty odhadovať.

V zásade robíme pomocníčka pre človeka, ktorý rozhodne, či je niečo hoax. Ak si napríklad predstavíme moderátora nejakého fóra, ktorý musí posúdiť sto nových príspevkov, umelá inteligencia mu z nich môže vybrať tých zopár najpravdepodobnejšie dezinformačných.

Ako ste sa k tomuto typu projektov dostali?

Téme dezinformácií sa s viacerými kolegami venujeme už takmer päť rokov, dlho ich vnímame ako spoločenský problém. So študentmi sme kedysi pracovali na projekte detekcie nenávistných prejavov. Robili sme výskum za pomoci metód, ktoré by sa dali uplatniť aj na dezinformácie. Bol zameraný na charakterizáciu textu, ten sa totiž dá rôzne klasifikovať, napríklad ako nahnevaný, veselý, neutrálny. Získali sme vtedy grant a odvtedy sme sa tejto oblasti venovali podrobnejšie.

Najviac vašu pozornosť zaujme obsah, ktorý je emocionálny. Na jednom konci spektra sú mačičky, ale tie vás nezaujmú až tak ako niečo, čo vás rozčúli a negatívne chytí za srdce.

Problém s dezinformáciami sa medzitým nevyriešil, skôr sa zhoršil, a preto sme pri ňom vytrvali. Takýto detektor hoaxov sa pokúša vo svete vytvoriť veľa výskumníkov, no my ho aplikujeme čiastočne aj na slovenčinu, čo už tak veľa ľudí nerobí. Slovenčinou hovorí málo ľudí a je preň k dizpozícii málo zdrojov.

Ako detektor funguje?

Predstavte si čiernu skrinku, do ktorej nevidíte. Jej vnútro je komplikované, ale nemusí nás v prvom priblížení príliš zaujímať. Skrinka však navonok funguje tak, že do nej vkladáme veľa príkladov, napríklad viet. Napríklad do nej z jednej strany vložíme dve vety a chceme, aby nám na druhej strane vyhodnotila, či sú významovo podobné alebo totožné.

Ak k tomu mám k dispozícii databázu nepravdivých výrokov, povedzme často sa opakujúcich hoaxov napríklad v medicínskej doméne, môžem výskyt podobných či rovnakých myšlienok detegovať v novom obsahu. Škatuľku vieme vyrobiť jednoducho, to, čo je na tom celom ťažké, je získavanie spoľahlivých ohodnotených dát.

Hoaxy sú však často nové informácie. Vezmime si príklad: v minulosti niekto správne vyhodnotil, že správa o tom, že Savo lieči rakovinu, je hoax. Potom príde nová dezinformácia, že cukríky liečia rakovinu. Ako si skrinka vyhodnotí, že aj tá nová informácia je hoax?

V prvom rade si technológia dokáže všimnúť, čo majú vety spoločné. Obe vety majú dve rovnaké slová: lieči a rakovinu. Strojčeky vidia aj väzbu medzi slovami, teda že sa vety skladajú z podmetu, prísudku a predmetu. Škatuľka môže byť vnútri umelou neurónovou sieťou zloženou podobne ako náš mozog. V prepojeniach neurónov je zakódované, čo už videla predtým. Pozrie sa na nový príklad a vie povedať, že na základe podobností je to na 80 percent pravdepodobne hoax, lebo vidí znaky charakteristické pre hoaxy.

Hodnotíte hoaxy na úrovni odsekov alebo viet? Dokáže stroj porozumieť celému textu?

Stroj v skutočnosti textu nerozumie v zmysle, ako to chápeme my ľudia, od toho sme zatiaľ veľmi ďaleko a neviem, či sa k tomu vôbec niekedy dopracujeme. Stroje však vedia robiť niektoré úlohy, pri ktorých sa javí, že textu rozumejú. Sú modely, ktoré posudzujú vetu podľa iných viet, respektíve výrokov, ale niekedy aj celých článkov. Niektoré prístupy nakrájajú text na vety a vyhodnotenie je len agregované. Iné hľadajú súvislosti medzi informáciami.

Detektor hoaxov sa pokúša vo svete vytvoriť veľa výskumníkov, no my ho aplikujeme čiastočne aj na slovenčinu, čo už tak veľa ľudí nerobí.

Ako môžu ľudia umelej inteligencii pomôcť??

Ľudí potrebujeme pri použití detekčného modelu. Môžete byť napríklad moderátorom fóra, ktorý nestíha čítať všetky príspevky a potrebuje pomoc pri ich filtrovaní. Využiť ho môže aj factchecker, ktorý si potrebuje overiť napríklad výroky politikov a zisťuje, či nepovedali nejaký nezmysel.

Pri zložitejších obsahoch je to veľa práce a niektoré z úkonov by mohli byť automatizované. Napríklad strojček zistí, či už podobný výrok nebol v minulosti overovaný. Ľudí potrebujeme aj pri zbere dát. Ak narazia na dezinformácie alebo nenávistné komentáre, môžu ich označiť alebo im napísať anotáciu a my to neskôr môžeme zaradiť do databázy pre umelú inteligenciu. Môže sa prihlásiť každý.

Mohli by sa zapojiť aj ľudia, ktorí dezinformácie šíria?

Žiaľ, mohli. My sme zatiaľ spravili iba úvodnú štúdiu, zozbierali sme dáta. Sledujeme, či to ľuďom dáva zmysel, zatiaľ sme nezhodnotili kvalitu ich práce. Keby sa ukázalo, že to nemôže byť otvorený nástroj, budú doň prispievať iba vyškolení ľudia, skupina, ktorá by prešla výberovým konaním.

Možno by sa mohol prihlásiť ktokoľvek, musel by však prejsť kurzom a občas by sme ho potom skontrolovali. Keby neprodukoval dáta kvality, akú by sme potrebovali, jeho dáta nepoužijeme. Tomuto sa venuje oblasť s názvom crowdsourcing, ktorá sa zaoberá tým, ako využívať veľké skupiny anonymných používateľov, a má veľa nástrojov, ktorými si poisťuje kvalitu dát.

Podľa čoho sa obsah vyhodnocuje? Aké môže mať kategórie?

My im vravíme črty. Môžeme sledovať, či je obsah emočne zafarbený, kde sa vyskytol, aké reakcie vyvolal, kto ho zdieľal. Potom je v texte veľa nadávok, interpunkcie, neprimerane veľa kapitálok. Okrem toho si modely všímajú aj vecnú podstatu obsahu, teda jeho tému či koncepty, ktoré spomína. Žiadna z týchto čŕt nám sama osebe nepovie správny výsledok, no model umelej inteligencie ich posúdi spolu.

Ľudí potrebujeme aj pri zbere dát. Ak narazia na dezinformácie, môžu ich označiť a my to neskôr môžeme zaradiť do databázy pre umelú inteligenciu.

Spomenuli ste, že za ten čas, čo sa dezinformáciám venujete, sa situácia zhoršila. Nestíhame za hoaxmi?

Momentálne skutočne ťaháme za kratší povraz. S oneskorením zisťujeme, aké negatívne dôsledky má pre nás nasadenie nových technológií, teda napríklad sociálnych médií. Ja som však optimista, nemyslím si, že smerujeme do záhuby, ale tento problém nás ešte môže zabolieť na mnohých miestach.

Našťastie, ľudia ho už vnímajú, rovnako aj regulátori, teda štáty, ktoré začínajú tlačiť na veľké technologické firmy, aby niečo podnikli. Tie už deklarovali, že sa budú samy regulovať, no odvtedy už prešiel istý čas a situácia sa nezlepšila. Budem to demonštrovať na našom nedávnom výskume. Pred rokom sme sa pustili do auditovania algoritmov na sociálnych sieťach. Pomocou auditu dokážeme zmerať, či algoritmus neprimerane neodporúča dezinformačný obsah.

Problém s hoaxmi je, že im verí veľa ľudí. Keď sa nevieme o realite presvedčiť navzájom, technológia to dokáže?

Umelá inteligencia ľudí nebude presviedčať. No ak sú zavretí v bubline, dostávajú rovnaké typy príspevkov a nemôžu si prečítať nič z druhého brehu, utvrdzujú sa vo vlastnom presvedčení.

Odporúčací algoritmus pre médium by mohol zabezpečiť pluralitu, aby človek nezostal v bubline. Zoberme si otázku: mali by byť obedy v škole zadarmo? Zatiaľ to s hoaxmi nemá nič spoločné, ale asi nie je v poriadku, ak sa mi na sieti ukazujú len články, kde sa tvrdí len jedna vec. Keď si čítam informácie z oboch strán, mám šancu uvedomiť si argumenty za a proti. Pripomínam však, že problém by sme tu mali aj bez technológií. Ľudia nerozmýšľajú kriticky, sú sebeckí, krátkozrako sa nezaujímajú o problémy druhých, preferujú jednoduché riešenia, ktoré nemusia byť správne. Toto všetko technológie len zhoršujú a našou úlohou je pomôcť tento negatívny príspevok zmierniť.

Spoločnost O2 dlhododobo podporuje mediálnu gramotnosť, preto prostredníctvom Férovej Nadácie O2 podporila projekty zamerané na kultiváciu informačného priestoru a publikovanie overených informácií. Spolu s KInIT-om uspelo v grantovom programe Vráťme rozum na internet minulý rok 12 projektov zameraných na kritické myslenie. Viac informácií nájdete na tomto mieste.